Robots.txt is een bestand dat door zoekmachine robots wordt gebruikt om te achterhalen welke delen van je website wel of niet doorzocht mogen worden. Het bestand is een voor iedereen toegankelijk bestand. Dit betekent dat iedereen, ook zonder in te loggen, de robots.txt van een website in kan zien. Zo ook van Lap Marketing. Een voorbeeld van onze robots.txt bestand vind je hier.

Het instellen van de robots.txt valt onder de technische SEO optimalisaties. Het instellen van een robots.txt bestand lijkt een minimaal onderdeel en wordt daardoor regelmatig over het hoofd gezien. Toch heeft een goed ingestelde robots.txt een grote impact op de vindbaarheid van je website.

Hoe werkt het robots.txt bestand?

Met een robots.txt bestand geef je Google richtlijnen over hoe het jouw website moet doorlopen. Het bestand geeft aan welke gedeeltes van de website gecrawld moeten worden, en welke onderdelen op de website overgeslagen mogen worden. De regels die je aanbrengt hebben sterke invloeden op de resultaten, maar zijn geen verplichtingen. Zo is Google vrij om de robots.txt te negeren en een eigen plan te trekken. Een zoekmachine als Google kan er dus voor kiezen om gedeeltes van de robots.txt te negeren.

Waar vind ik de robots.txt?

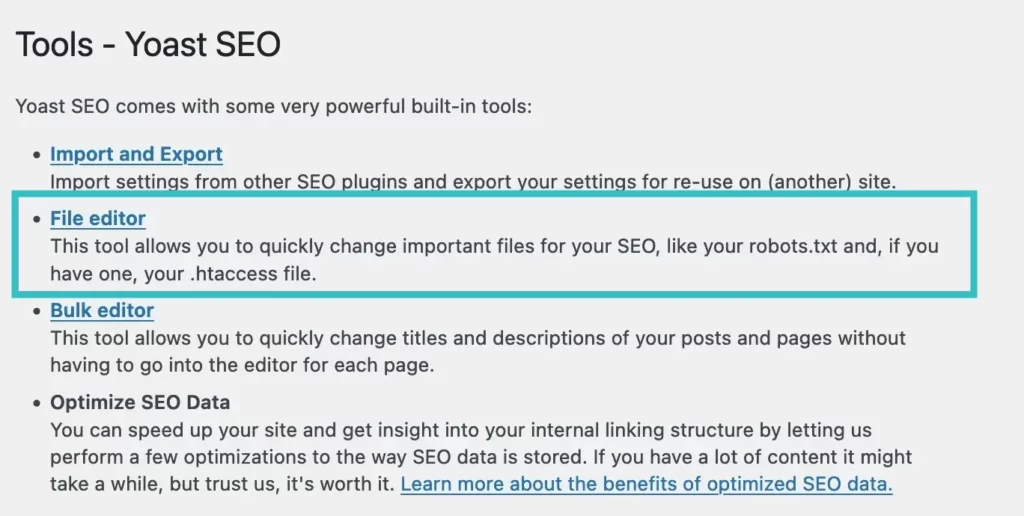

Het robots.txt staat in de root van het domein en kan gevonden worden door via FileZilla de FTP gegevens van een website te openen. Daarnaast zijn er verschillende plugins die het mogelijk maken om aanpassingen te maken binnen de Robots.txt. Eén van deze plugins is Yoast. Via Yoast is het mogelijk om bestanden als de robots.txt en de .htaccess direct aan te passen.

Dit kan door in WordPress naar Yoast SEO > Gereedschap / Tools > File editor te gaan.

Waar dient de robots.txt voor?

Wanneer je website geen robots.txt bestand heeft, dan wordt de gehele website gecrawlt. Dit betekent dat bepaalde pagina’s, zoals de inlogpagina van de website of de checkout pagina ook in Google terecht komt. In veel gevallen wil je liever niet dat dit gebeurt. Het aanbrengen van een goede Robots.txt is van belang om de volgende redenen:

1. Het optimaliseren van het crawl budget

De crawlers van Google komen om de zoveel tijd op je website terecht. Dit wordt een crawl genoemd. Het crawlbudget is het aantal pagina’s dat Google op dat moment op de website zal crawlen. Het uitvoeren van zo’n crawl kost Google rekenkracht. Om deze krachten eerlijk te verdelen, wordt er per website een crawlbudget bepaald.

Zonder robots.txt bestand wordt dit budget verbruikt aan de verkeerde pagina’s. Wanneer het crawlbudget van de website wordt overschreden, dan kan het zijn dat bepaalde belangrijke pagina’s niet geïndexeerd worden.

2. Duplicate content tegengaan

Google hoeft niet elke pagina op jouw website te indexeren. Producten die onder meerdere categorieën vallen, woorden die worden ingevuld in de zoekfunctie op de website creëren al snel verschillende url’s. Wanneer deze pagina’s geïndexeerd worden, dan ontstaat er duplicate content. Dat is niet bevordelijk voor de SEO. Met behulp van de robots.txt kan je deze pagina’s gemakkelijk excluden.

3. Verbergen van bepaalde bestanden

In sommige gevallen wil je ervoor zorgen dat bestanden als PDF’s, video’s en afbeeldingen niet weergegeven worden in de zoekresultaten. Daarnaast kan het een bewuste keuze zijn om deze niet te indexeren, zodat Google zich kan focussen op belangrijkere onderdelen van de website. Door hiervoor aanwijzigingen op te nemen in de robots.txt, kan je ervoor zorgen dat deze pagina’s niet geïndexeerd worden.

Hoe stel je een robots.txt bestand op?

Het is belangrijk om je robots.txt bestand goed in te stellen. Wanneer dit niet juist wordt gedaan, dan raken de zoekmachines in de war. Vrijwel alle grote zoekmachines, waaronder Google en Bing hebben hier richtlijnen voor opgesteld. Deze richtlijnen geven aan hoe je het bestand zo in moet richten, zodat beide zoekmachines hier goed mee kunnen werken.

Bij het instellen van een robots.txt bestand, zijn een aantal regels belangrijk om te onthouden. Deze zijn als volgt:

- Het gebruik van User-agent;

- Het gebruik van Disallow en Allow;

- Het gebruik van Wildcards;

- Het gebruik van een sitemap.

User-agent:

In veel gevallen begint het opstellen van het Robots.txt bestand bij het bepalen van de crawler/spider die wordt aangesproken. Dit noemen ze de User-agent. De user-agent is als het ware de naam van de zoekmachine die wordt aangesproken. Je kunt ervoor kiezen om alle zoekmachines in één blok aan te spreken, of om alle zoekmachines aparte instructies mee te geven. Uiteindelijk zal een spider altijd kiezen voor een user-agent die het beste aansluit bij zijn naam.

Wanneer je alle zoekmachines in één keer aan wilt spreken, dan zet je het volgende in de robots.txt:

| User-agent: * |

Wanneer je voor de verschillende zoekmachines aparte user-agents wilt instellen, dan doe je dit als volgt:

| User-agent: * Disallow: / User-agent: Googlebot Disallow: User-agent: bingbot Disallow: /not-for-bing/ User-agent: Ahrefsbot Disallow: User-agent: Semrushbot-SI Allow: |

Disallow

Nu je weet wat een User-agent is, wordt het tijd om de term disallow toe te lichten. De disallow term wordt gebruikt om aan te geven tot welke delen de crawlers geen toegang hebben. Je kunt meerdere disallow regels toevoegen. Een lege ‘disallow’ regel betekent dat je geen richtlijnen opstelt. Dit betekent indirect dat Google toegang heeft tot alle delen van de website.

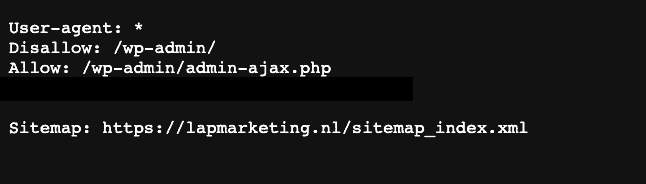

Bij WordPress staan er automatisch al wat onderdelen bij “Disallow”. In dit geval ziet de robots.txt er als volgt uit:

Allow

Zoals je al wel kan raden, betekent de functie ‘Allow’ precies het tegenover gestelde van ‘Disallow’. Door middel van de het ‘Allow’ command, kan je richtlijnen opstellen waarmee Google in een niet toegestaan gedeelte, toch één pagina kan indexeren.

Wildcard: *

Binnen de Robots.txt is het ook mogelijk om richtlijnen aan te brengen door middel van een Wildcard. Met een * kan je richtlijnen aanbrengen aan elke user-agent. Dit betekent dat de regel van toepassing is op alle bots, in plaats van op een specifieke bot.

Stel dat je je website wilt laten indexeren in alle zoekmachines, behalve Bing. Dan ziet je robots.txt er als volgt uit:

| User-agent: bingbot Disallow: / User-agent: * Allow: / |

Sitemap

Om het voor Google zo makkelijk mogelijk te maken, doe je er goed aan om in je robots.txt ook aan te geven waar Google je Sitemap kan vinden. Dit doe je door aan de Robots.txt file de volgende regel toe te voegen:

| Sitemap: https://lapmarketing.nl/sitemap_index.xml |

Let er hierbij op dat je de url van bovenstaande link aanpast naar je eigen website.

Wil je meer weten over het gebruik van een Robots.txt bestand? Neem dan gerust contact met ons op. We leggen het je graag verder uit.